目录

一、前言:

二、YOLOv7代码下载

三、环境配置

四、测试结果

五、制作自己的数据集

六、训练自己的数据集

一、前言:

上一篇已经详细讲解了如何安装深度学习所需要的环境,这一篇则详细讲解如何配置YOLOv7,在本地电脑或者服务器都可,然后利用自己的数据集进行训练、推理、检测等。

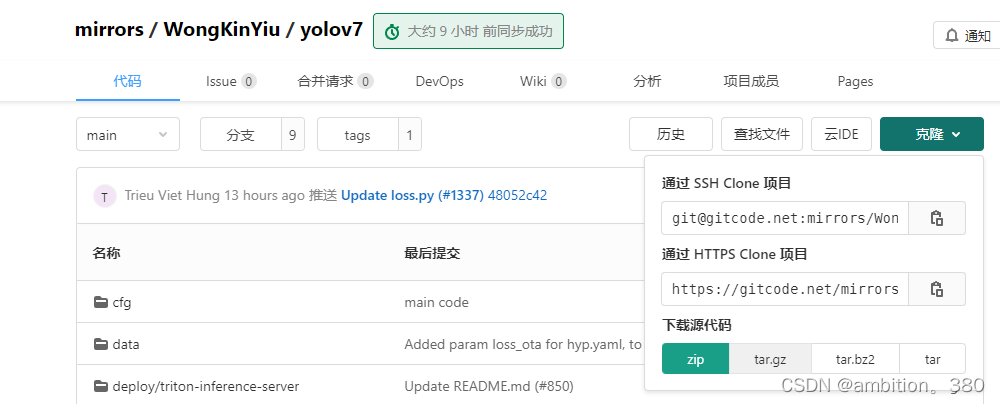

二、YOLOv7代码下载

YOLOv7是原YOLOv4团队打造,在精度与速度之间取得较好的平衡,并且是现在较为优秀的目标检测模型

论文地址:https://arxiv.org/abs/2207.02696

论文代码下载地址:mirrors / WongKinYiu / yolov7 · GitCode

这块直接下载zip安装包打开就可以了。

三、环境配置

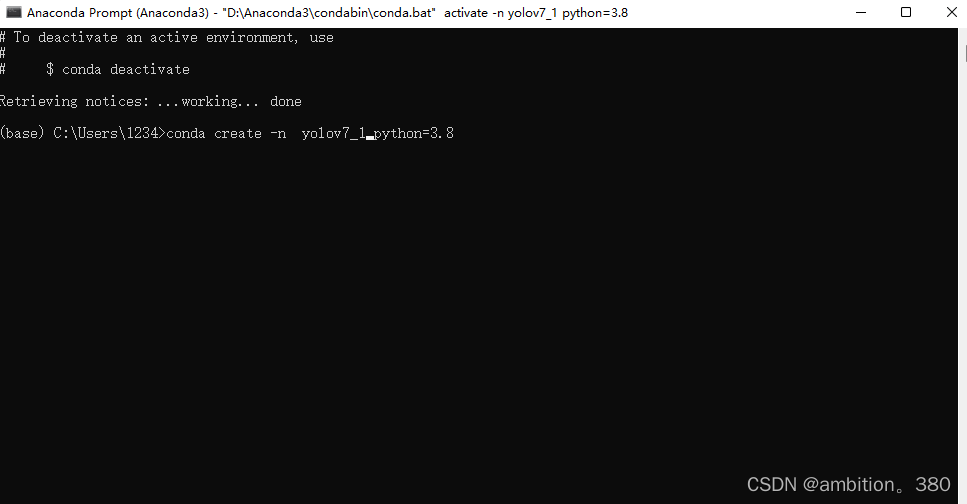

如果是windows系统的话,打开Anaconda的终端。如果是远程服务器的话,直接创建一个就可以了。剩下的windows和服务器都是一个操作了。

如下:输入 conda create -n yolov7(代表环境名称) python=3.8 (使用Python的版本),然后创建就可以了

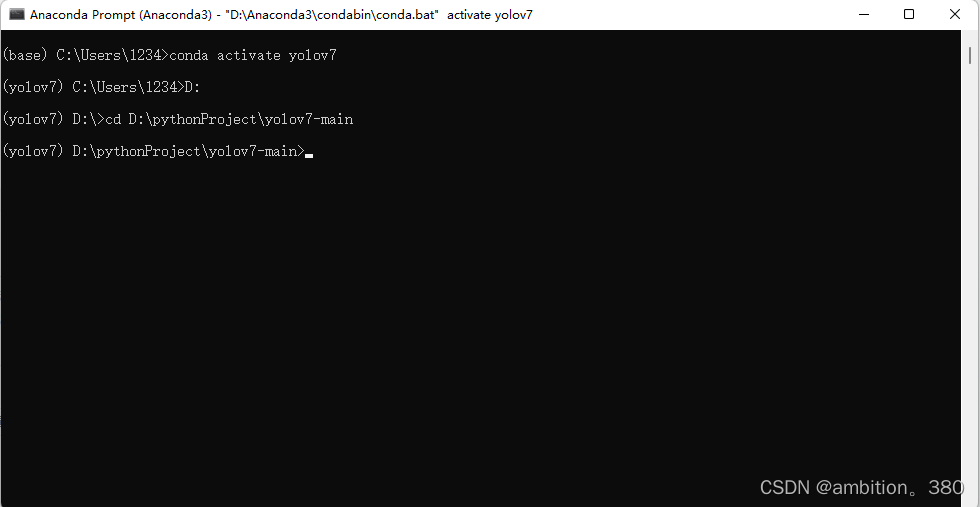

环境安装完成后,conda activate yolov7进入刚才创建的环境(这块我设置的为yolov7_1,只是一个名称,无伤大雅)

然后cd切换至刚才下载解压后的yolov7-main文件夹中

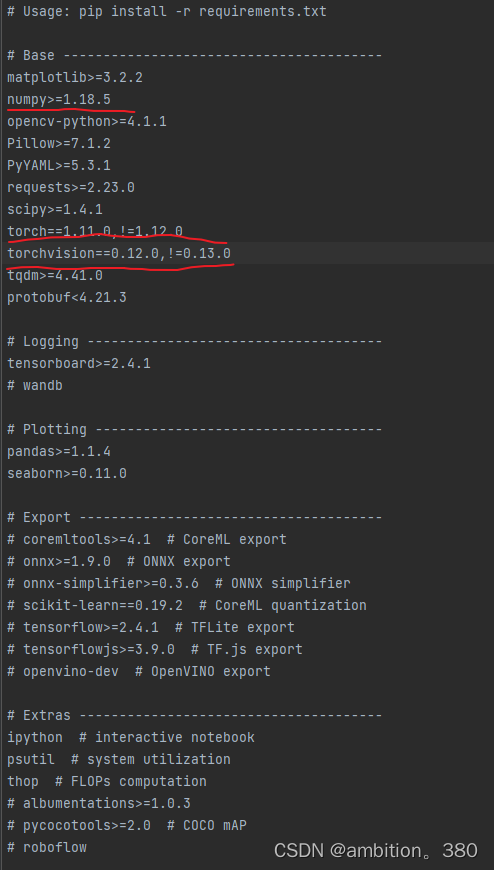

接下来安装requirements.txt文件就可以了,后面加这个清华的镜像源会快点。

pip install -r requirements.txt -i https://pypi.tuna.tsinghua.edu.cn/simple

这块,我个人的torch与trochvison是直接指定的,你们按照官方来的就可以。(这块库里也写了torch版本不能等于1.12.0,torchvision不能等于0.13.0,所以一定要注意。)

接下来有一个很重要的点一定要强调!!!

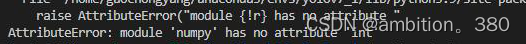

(1)numpy库如果安装最新的1.24.1,会发生module numpy has no attribute int 错误,这个错误我找了很久, 这个是因为numpy版本的原因,1.24以上的版本没有int了,改为inf了,换成1.23的版本就好了,或者把报错出的int改成inf就可以了,所以requirements.txt中的numpy库建议直接替换成numpy==1.23.0,这个就没有问题了。

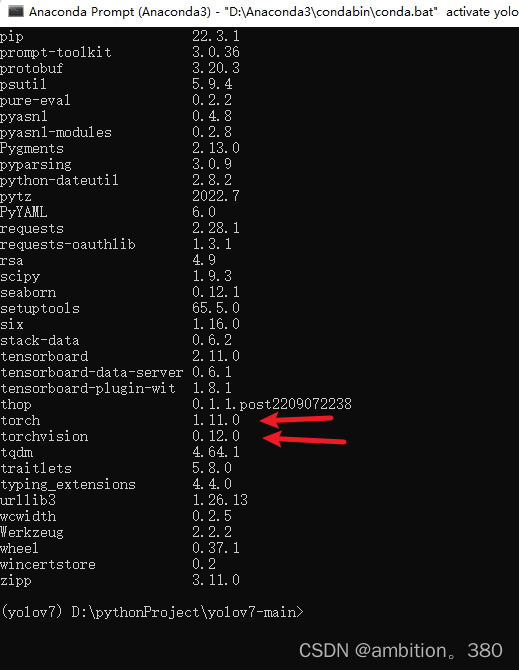

等安装输入pip list 可以查看一下安装的对不对

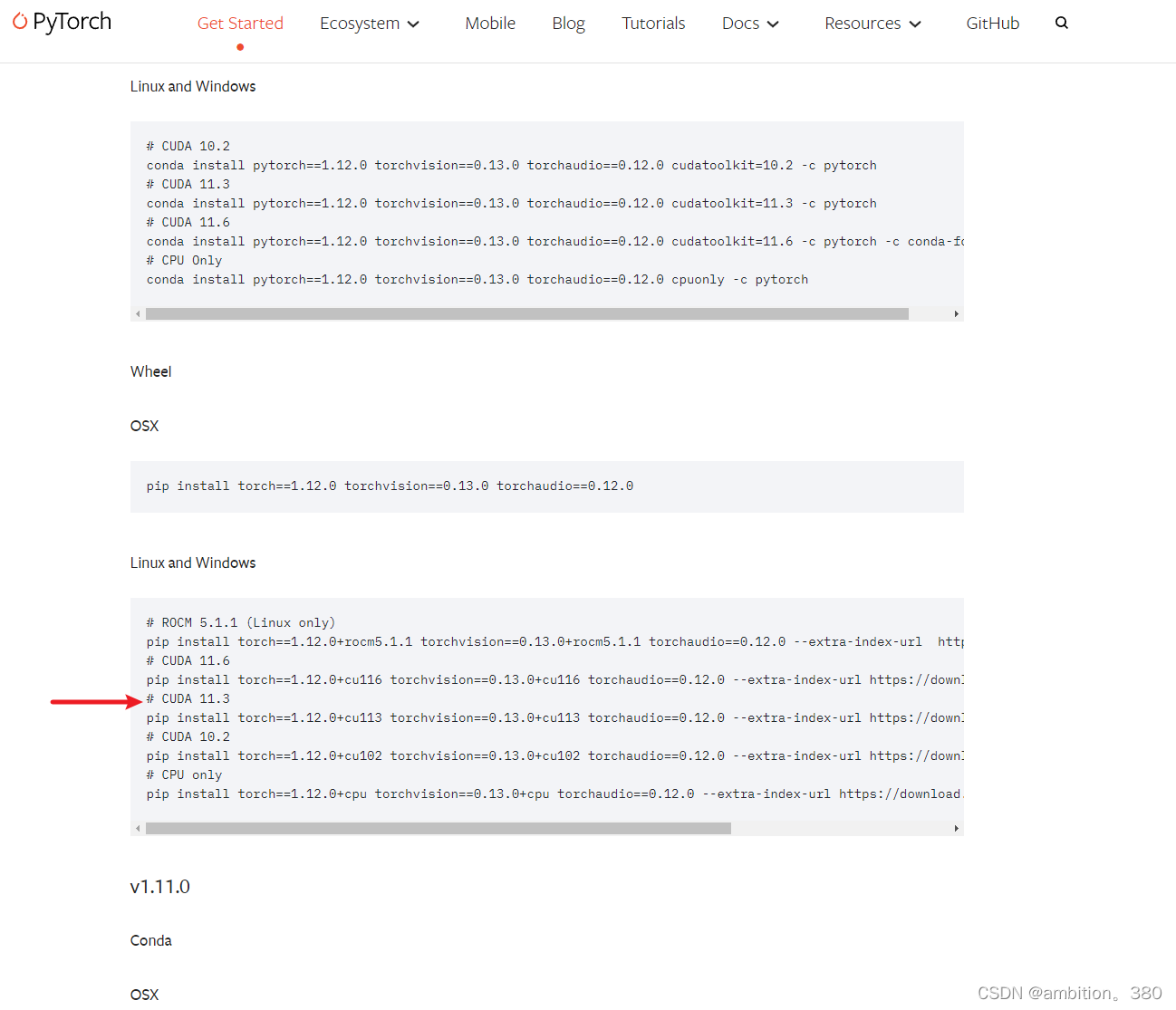

这块其实就能看到,其实torch和torchvision都是cpu版本的,而不是gpu版本的, 需要在这个网站上找寻适合自己cuda版本的torch口令然后下载

pytorch下载地址:Previous PyTorch Versions | PyTorch

例如我的是11.3的cuda版本复制这条指令

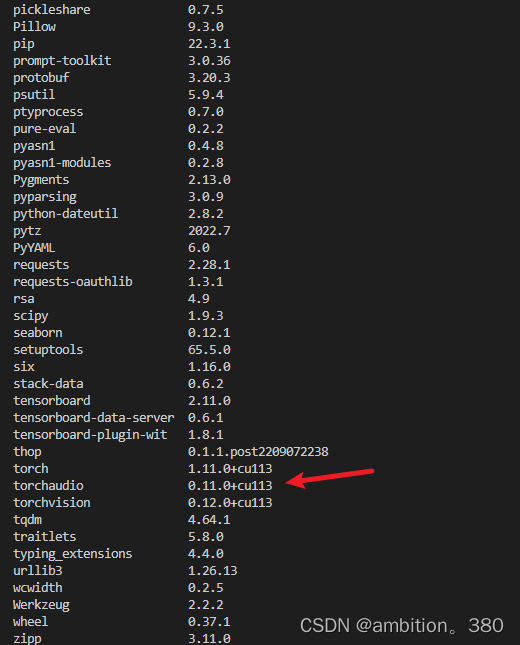

pip install torch==1.11.0+cu113 torchvision==0.12.0+cu113 torchaudio==0.11.0 --extra-index-url https://download.pytorch.org/whl/cu113

等安装完毕后 就可以看到后面多了+cu113,gpu的训练环境就基本配置结束了。

四、测试结果

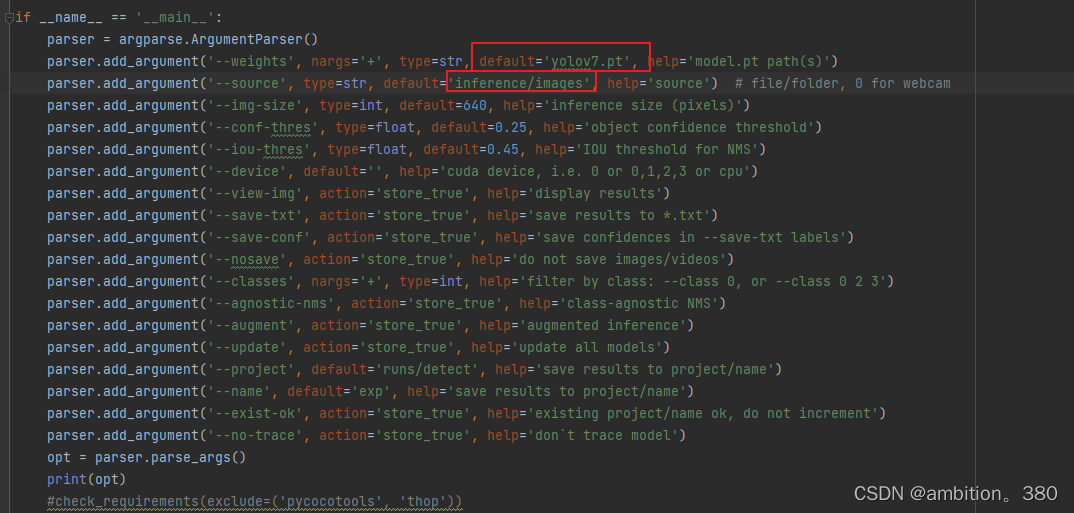

此时打开detect.py,--wgeights中的default需要修改为下载的权重,具体地址在YOLOv7源码下载页面的下面

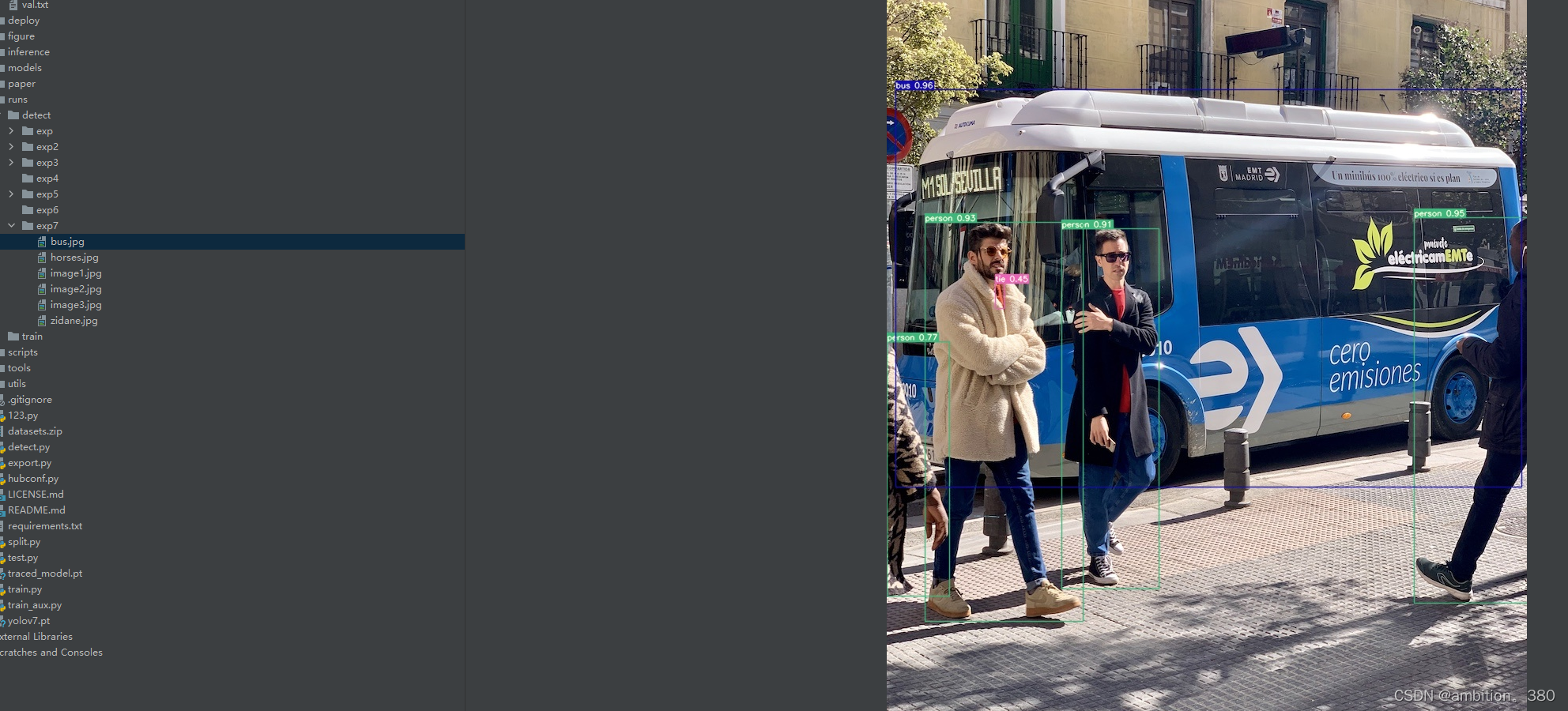

detect后在runs中找检测后的图,如果出现检测框就说明模型基本布置完成 。

这块说一下第二个重要的点

(2)如果你的项目场景如下:

操作系统为win10或者win11

GPU:RTX1650、1660、1660Ti,会发生在cpu的torch环境中跑出检测框来,但是gpu中无法识别检测框

像上图所示,博主本人电脑是1660Ti的,个人猜测原因这是由于 RTX1660Ti没有达到CUDnn_Half

使用要求,yolov7的话就在主函数中添加:

torch.backends.cudnn.enabled = False五、制作自己的数据集

数据集制作这块要仔细,毕竟需要看模型训练出来的好坏,进行改进。

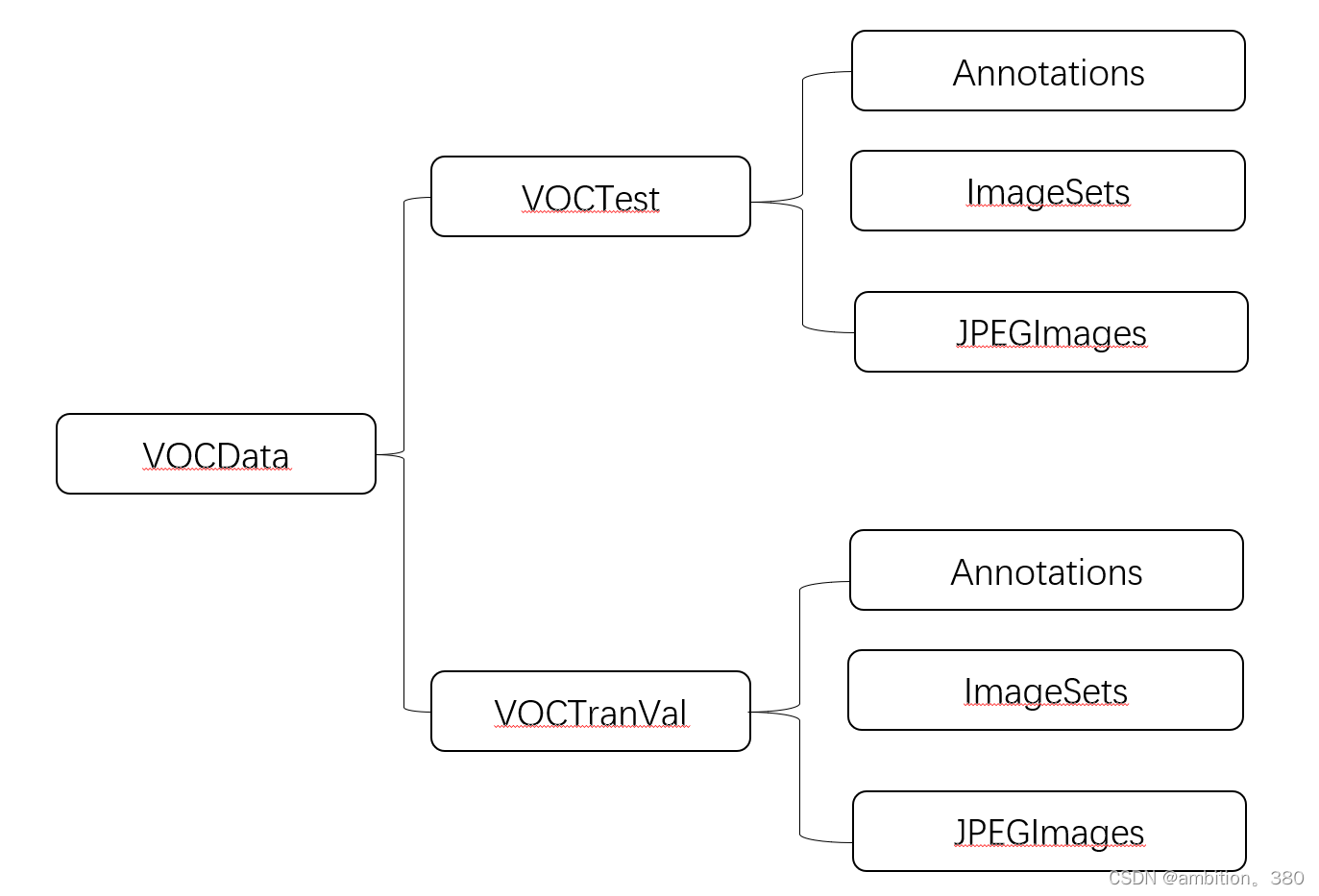

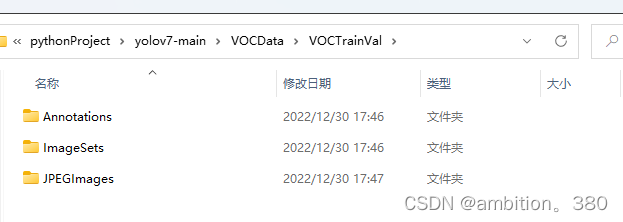

文件夹设置如下

Annotations为数据集的xml文件,ImageStes中再创建一个Main文件夹,JPEGImages为数据集的图片,接下来需要将xml文件划分,再转为txt文件,因为yolo使用的是txt格式的,

创建一个split.py文件,将下面代码粘贴进去,这块只写了训练集和验证集,并没有测试集,需要可以再自己更改重写

- import os

- import random

-

- xmlfilepath = r'../VOCData/VOCTrainVal/Annotations/' # xml文件的路径

- saveBasePath = r'../VOCData/VOCTrainVal/ImageSets/' # 生成的txt文件的保存路径

-

- trainval_percent = 0.9 # 训练验证集占整个数据集的比重(划分训练集和测试验证集)

- train_percent = 0.9 # 训练集占整个训练验证集的比重(划分训练集和验证集)

- total_xml = os.listdir(xmlfilepath)

- num = len(total_xml)

- list = range(num)

- tv = int(num * trainval_percent)

- tr = int(tv * train_percent)

- trainval = random.sample(list, tv)

- train = random.sample(trainval, tr)

-

- print("train and val size", tv)

- print("traub suze", tr)

- ftrainval = open(os.path.join(saveBasePath, 'Main/trainval.txt'), 'w')

- ftest = open(os.path.join(saveBasePath, 'Main/test.txt'), 'w')

- ftrain = open(os.path.join(saveBasePath, 'Main/train.txt'), 'w')

- fval = open(os.path.join(saveBasePath, 'Main/val.txt'), 'w')

-

- for i in list:

- name = total_xml[i][:-4] + '\n'

- if i in trainval:

- ftrainval.write(name)

- if i in train:

- ftrain.write(name)

- else:

- fval.write(name)

- else:

- ftest.write(name)

-

- ftrainval.close()

- ftrain.close()

- fval.close()

- ftest.close()

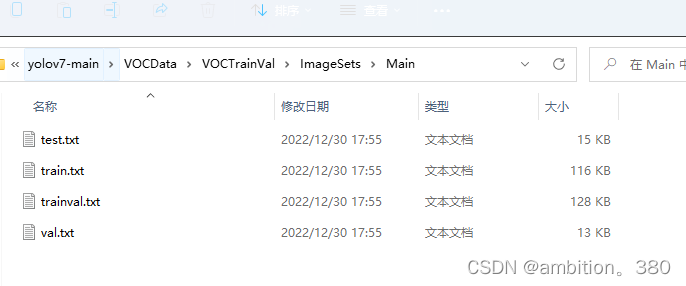

可以看到输出结果,将数据集划分后,生成四个txt文件

然后再将xml文件转化为txt文件

这块创建一个voc_label.py文件

- import xml.etree.ElementTree as ET

- import pickle

- import os

- from os import listdir, getcwd

- from os.path import join

- import shutil

-

- sets=[('TrainVal', 'train'), ('TrainVal', 'val'), ('Test', 'test')]

-

- classes =["mask_weared_incorrect","with_mask","without_mask"]

-

- def convert(size, box):

- dw = 1./size[0]

- dh = 1./size[1]

- x = (box[0] + box[1])/2.0

- y = (box[2] + box[3])/2.0

- w = box[1] - box[0]

- h = box[3] - box[2]

- x = x*dw

- w = w*dw

- y = y*dh

- h = h*dh

- return (x,y,w,h)

-

- def convert_annotation(year, image_set, image_id):

- in_file = open('VOC%s/Annotations/%s.xml'%(year, image_id))

- out_file = open('VOC%s/labels/%s_%s/%s.txt'%(year, year, image_set, image_id), 'w',encoding='utf-8')

- tree=ET.parse(in_file)

- root = tree.getroot()

- size = root.find('size')

- w = int(size.find('width').text)

- h = int(size.find('height').text)

-

- for obj in root.iter('object'):

- difficult = obj.find('difficult').text

- cls = obj.find('name').text

- if cls not in classes or int(difficult) == 1:

- continue

- cls_id = classes.index(cls)

- xmlbox = obj.find('bndbox')

- b = (float(xmlbox.find('xmin').text), float(xmlbox.find('xmax').text), float(xmlbox.find('ymin').text), float(xmlbox.find('ymax').text))

- bb = convert((w,h), b)

- out_file.write(str(cls_id) + " " + " ".join([str(a) for a in bb]) + '\n')

-

- def copy_images(year,image_set, image_id):

- in_file = 'VOC%s/JPEGImages/%s.jpg'%(year, image_id)

- out_flie = 'VOC%s/images/%s_%s/%s.jpg'%(year, year, image_set, image_id)

- shutil.copy(in_file, out_flie)

-

- wd = getcwd()

-

- for year, image_set in sets:

- if not os.path.exists('VOC%s/labels/%s_%s'%(year,year, image_set)):

- os.makedirs('VOC%s/labels/%s_%s'%(year,year, image_set))

- if not os.path.exists('VOC%s/images/%s_%s'%(year,year, image_set)):

- os.makedirs('VOC%s/images/%s_%s'%(year,year, image_set))

- image_ids = open('VOC%s/ImageSets/Main/%s.txt'%(year, image_set)).read().strip().split()

- list_file = open('VOC%s/%s_%s.txt'%(year, year, image_set), 'w')

- for image_id in image_ids:

- list_file.write('%s/VOC%s/images/%s_%s/%s.jpg\n'%(wd, year, year, image_set, image_id))

- convert_annotation(year, image_set, image_id)

- copy_images(year, image_set, image_id)

-

- list_file.close()

-

-

-

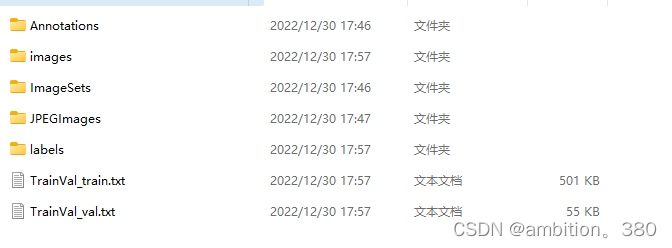

转换后会从三个文件夹变为五个文件夹,然后还有训练与验证的txt文件。

下一步创建自己数据集的yaml文件,这块我的文件命名为myvoc.yaml

- # 上面那三个txt文件的位置

- train: ./VOCData/VOCTrainVal/TrainVal_train.txt

- val: ./VOCData/VOCTrainVal/TrainVal_val.txt

- test: ./VOCData/VOCTest/Test_test.txt

- # number of classes

- nc: 3 # 修改为自己的类别数量

- # class names

- names: ["第一个标签", "第二个标签","第三个标签"] # 自己来的类别名称 0 ,1 , 2

标签有几类,那么nc类别就改为几个,进行到这,基本工作已经做齐,接下来就是训练。

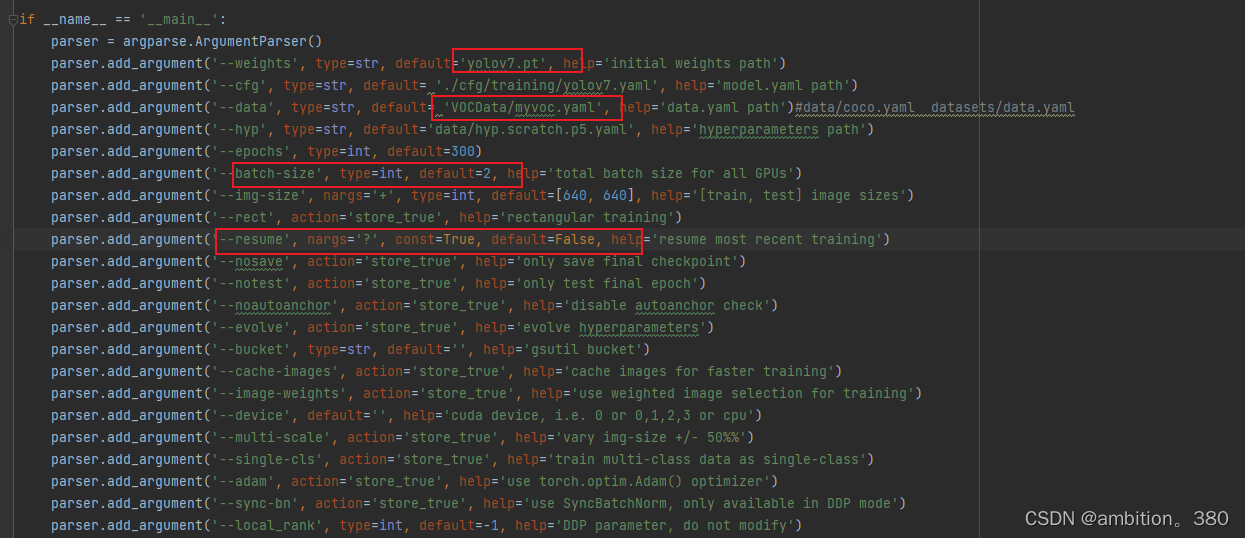

六、训练自己的数据集

--weights代表权重,可以使用默认权重,也可以不用预训练权重,也可以使用官方提供的训练权重yolov7_training.pt

--data代表数据集,这块就写入咱们刚才制作的数据集的位置就可以了,可以使用相对路径,也可以使用绝对路径

--batch-size代表大小,这个根据个人电脑情况调整,一般为2 - 16不等,均为偶数

--resume继续训练,如果因为断电或者其他不可抗力因素导致训练终止,将此处的default改为True,便可以接着上一次的训练。

接下来开始训练就可以了,如果是windows系统直接训练,若为服务器的话

输入下列指令

- python train.py --weights yolov7.pt --cfg ./cfg/training/yolov7.yaml

- --data VOCData/myvoc.yaml --device 0 --batch-size 2 --epoch 300

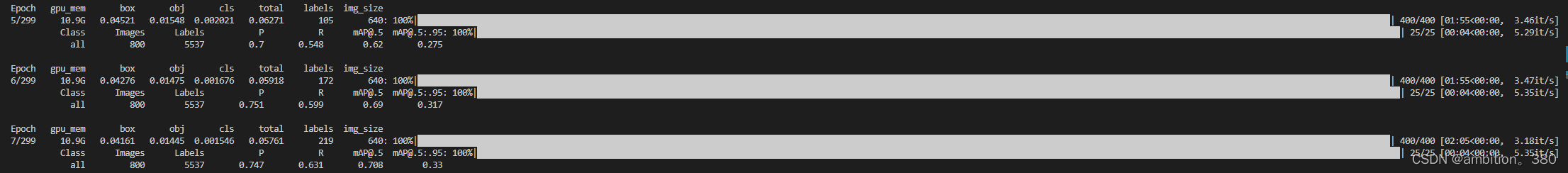

然后 就开始训练了,训练结果保存在runs/train/exp下,训练结束后就可以看到一系列数据了。

如果复现或者训练过程中遇到什么问题,可以私信博主,看到会及时回的,写作不易,烦请点个赞,一起学习进步。

2-16日更新

有很多同学私信表示会有这个UnicodeDecodeError: 'gbk' codec can't decode byte 0xae in position 34: illegal multibyte sequence的解码错误。

解决该问题第一步先检查xml文件是否含有中文路径,如果xml文件有中文路径,就会出现这种问题。

第二步,如果你是在windows平台训练,检查过后仍然存在这种问题,建议舍弃掉xml数据集,直接使用txt文件进行划分,因为yolo是通过xml转换为 txt文件进行训练,有帮同学用txt文件在windows上调试成功的。如果你只有xml文件,建议在linux环境下进行训练,v7的小问题比较多,个人用xml文件在Ubuntu成功运行,但是windows也会报错,所以windows平台建议txt格式的数据集。